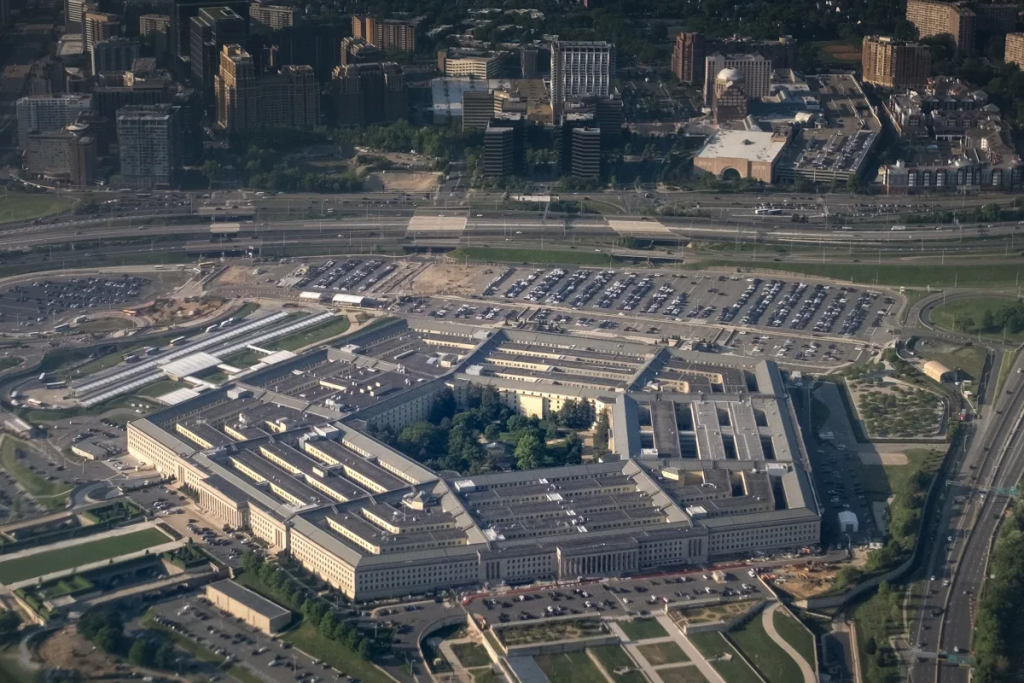

A tensão entre o Silicon Valley e o Departamento de Defesa dos Estados Unidos subiu de tom. No centro da polémica está a Anthropic, a empresa criadora do modelo Claude, que se encontra num impasse direto com o Pentágono. Em causa está uma exigência governamental para que as tecnologias de Inteligência Artificial sejam disponibilizadas para “todos os fins legais”, uma definição que a Anthropic considera demasiado vaga e perigosa para os seus princípios éticos.

Este braço de ferro coloca em risco um contrato de 200 milhões de dólares, mas a tecnológica parece determinada a não ceder em pontos que considera fundamentais. Enquanto outras gigantes do setor mostram maior flexibilidade perante as pressões militares, a Anthropic mantém-se como a principal voz dissidente nesta nova corrida aos armamentos digitais. Se acompanhas de perto a evolução da IA, percebes que este não é apenas um problema de negócios, mas sim um debate sobre o futuro da segurança global.

O dilema das armas autónomas e da vigilância em massa

O grande pomo da discórdia reside em dois pontos críticos que a Anthropic recusa ultrapassar: o desenvolvimento de armas totalmente autónomas e a implementação de sistemas de vigilância doméstica em massa. A empresa argumenta que a sua política de utilização estabelece limites rígidos para evitar que o Claude seja transformado numa ferramenta de opressão ou de guerra automatizada sem supervisão humana direta. É uma posição corajosa, especialmente quando o financiamento público está em jogo.

Por outro lado, o Pentágono, sob a atual administração, pressiona para que não existam restrições contratuais que limitem a aplicação da IA em operações militares. A visão do Departamento de Defesa é clara: se a tecnologia existe e é legal, os militares devem ter o direito de a utilizar para garantir a segurança nacional. No entanto, o que é “legal” pode variar consoante a interpretação política, e é precisamente esse o receio que mantém os executivos da Anthropic em estado de alerta.

Pressão sobre as gigantes: OpenAI, Google e xAI no radar

A Anthropic não é a única empresa nesta mira. Relatórios indicam que a Google, a OpenAI e a xAI de Elon Musk também receberam exigências semelhantes. A diferença reside na resposta de cada uma. Segundo fontes próximas do processo, pelo menos uma destas empresas já terá aceitado as condições do Pentágono, enquanto outras duas estão a negociar com uma postura muito mais flexível do que a da Anthropic. Isto cria um cenário de isolamento para a criadora do Claude, que se vê agora como o último baluarte de resistência ética.

Se fores um entusiasta de tecnologia, sabes que esta pressão governamental não é novidade, mas a escala atual é sem precedentes. A administração norte-americana quer garantir que as ferramentas mais avançadas de IA estão ao serviço do Estado, temendo que restrições éticas autoimpostas pelas empresas possam deixar o país em desvantagem perante adversários globais. É uma luta de gigantes onde a autonomia das empresas tecnológicas está a ser posta à prova de forma agressiva.

O precedente da Venezuela e o futuro do contrato milionário

A situação torna-se ainda mais complexa quando recordamos que o Claude já terá sido utilizado em operações militares reais. Informações recentes revelaram que a tecnologia da Anthropic foi empregue na operação que levou à captura de Nicolás Maduro, na Venezuela. Embora a empresa afirme que não discute operações específicas com o Departamento de Guerra, o facto de a sua ferramenta já estar no terreno complica o seu discurso de neutralidade e resistência.

A ameaça de cancelamento do contrato de 200 milhões de dólares é uma cartada pesada. Para uma empresa que gasta milhares de milhões no treino de modelos, perder este fluxo de receita é um golpe financeiro significativo. Contudo, a Anthropic foi fundada por ex-membros da OpenAI precisamente com o foco na segurança e na ética da IA. Ceder agora significaria trair a própria essência da sua fundação e dececionar investidores e utilizadores que acreditam numa abordagem mais cautelosa da tecnologia.

O que isto significa para ti enquanto utilizador consciente

Podes pensar que estas discussões de bastidores no Pentágono não te afetam, mas a verdade é que as decisões tomadas hoje moldam a forma como a IA será integrada na sociedade amanhã. Se permitirmos que os modelos de linguagem se tornem ferramentas de vigilância sem restrições, a tua privacidade e liberdade podem estar em causa. A resistência da Anthropic serve como um lembrete de que a tecnologia não deve evoluir num vácuo moral, independentemente do valor dos cheques oferecidos pelo governo.

Fica atento aos próximos capítulos desta novela tecnológica. O desfecho deste conflito poderá ditar se as empresas de IA continuarão a ser entidades independentes com bússolas éticas próprias ou se acabarão por se tornar extensões do complexo militar-industrial. No final do dia, a pergunta que fica no ar é: quanto vale a integridade de uma empresa face a uma montanha de dólares e à pressão de uma superpotência?

Deixa um comentário