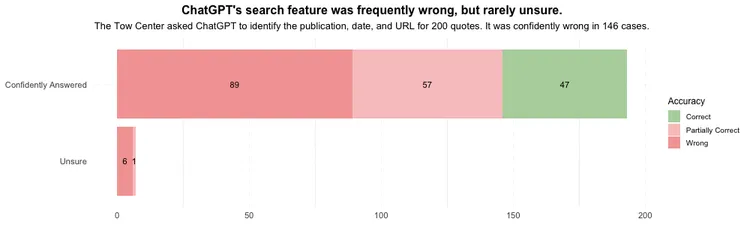

Uma investigação conduzida pela Universidade de Columbia revelou dados alarmantes sobre a precisão da ferramenta de pesquisa do ChatGPT.

O estudo, realizado pelo Centro Tow de Jornalismo Digital, demonstrou que a inteligência artificial falhou em fornecer informações precisas em mais de três quartos das pesquisas realizadas.

A análise focou-se em 200 citações provenientes de 20 publicações diferentes, testando a capacidade do ChatGPT em identificar corretamente as fontes e os contextos das informações.

Os resultados mostraram que em 153 casos, as respostas foram parcial ou totalmente incorretas.

O perigoso excesso de confiança da inteligência artificial

Um dos aspetos mais preocupantes revelados pela investigação foi a forma como o ChatGPT apresentou as suas respostas incorretas. Em apenas sete ocasiões, a IA admitiu não ter certeza sobre a informação fornecida, utilizando termos como “parece” ou “é possível”.

Esta confiança excessiva em informações erradas levanta questões sérias sobre a fiabilidade da ferramenta para pesquisas jornalísticas e académicas.

Em diversos casos, o sistema atribuiu citações a fontes completamente erradas, incluindo um caso em que uma carta ao editor do Orlando Sentinel foi incorretamente atribuída a um artigo da Time.

Problemas de atribuição e plágio detetados no sistema

A investigação também identificou situações em que o ChatGPT direcionou utilizadores para sites que haviam plagiado conteúdo original.

Num caso específico, quando questionado sobre uma citação de um artigo do New York Times sobre baleias em risco de extinção, o sistema forneceu um link para um website que tinha copiado o conteúdo na íntegra.

Esta descoberta sublinha preocupações sobre como a ferramenta pode inadvertidamente promover conteúdo plagiado e desinformação, mesmo quando existe um acordo de partilha de dados entre a OpenAI e os editores originais.

A resposta da OpenAI e as implicações futuras

A OpenAI respondeu às conclusões do estudo questionando a metodologia utilizada. A empresa argumentou que o teste representa um uso atípico do seu produto e prometeu continuar a melhorar os resultados das pesquisas.

No entanto, estas descobertas levantam questões importantes sobre a confiabilidade das ferramentas de IA para pesquisas de informação.

Os investigadores sugerem que é necessária uma maior transparência e precisão nos sistemas de IA, especialmente quando estes são utilizados como ferramentas de pesquisa e verificação de factos.

A necessidade de verificação humana continua a ser crucial, especialmente em contextos profissionais e académicos onde a precisão da informação é fundamental.

Este estudo serve como um importante lembrete de que, apesar dos avanços tecnológicos, as ferramentas de IA ainda não podem substituir completamente a verificação tradicional de fontes e factos.

Deixa um comentário